요약

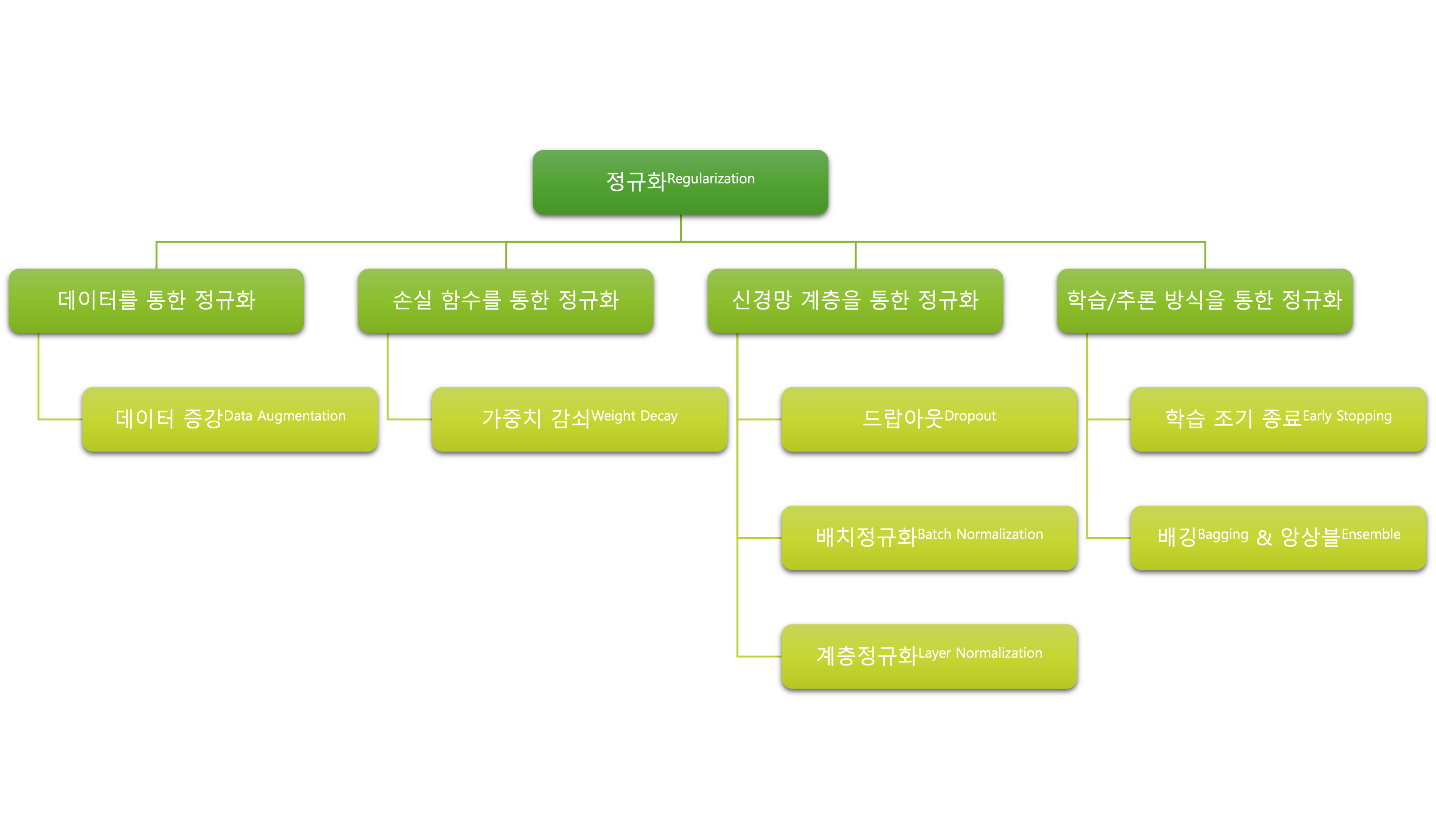

- 정규화regularization

- 오버피팅에 대한 관점에서, 정규화란 오버피팅을 늦추고 모델이 학습데이터로부터 적절한 특징feature들을 학습하여 일반화 오차generalization error를 낮춰줄 수 있는 기법

- 대부분의 정규화 계층 기법들은 학습과 추론 모드를 별도로 가지고 있음

- 드랍아웃

- 학습시 임의의 확률 $p$ (e.g. 0.2)로 신경망의 노드를 비활성화

- 추론시 모든 노드를 활성화 및 계층의 출력에 $\frac{1}{1-p}$ 를 곱해줌

- 배치정규화batch normalization

- 하이퍼 파라미터가 추가되지 않음

- 정규화가 수행될 뿐만 아니라 학습 손실도 빠르게 감소

- RNN 계열을 제외하고 거의 대부분 적용 가능

- 추론시에는 학습과 달리 미니배치의 평균을 구하지 않고, 이동평균을 활용하여 정규화